Apa yang Sebenarnya ‘Dilihat’ AI Saat Mengambil Keputusan?

Kecerdasan buatan kini mampu mengambil keputusan dalam hitungan detik, mulai dari menentukan kelayakan kredit, mengenali wajah, hingga membantu membaca citra medis. Namun di balik semua itu, ada satu pertanyaan mendasar yang sering terlewat: apa yang sebenarnya “dilihat” AI ketika ia mengambil sebuah keputusan? Pertanyaan ini penting, karena keputusan AI semakin sering memengaruhi hidup manusia secara langsung.

Gambar 1: Ilustrasi konsep “black box” pada kecerdasan buatan,

Gambar 1: Ilustrasi konsep “black box” pada kecerdasan buatan,

di mana proses pengambilan keputusan sulit dipahami manusia.

Manusia melihat dunia melalui makna seperti wajah, ekspresi, pola, dan konteks. Sebaliknya, AI tidak benar-benar “melihat” seperti manusia. Ia membaca angka, intensitas piksel, pola statistik, serta hubungan matematis antar data. Gambar bagi manusia adalah visual, tetapi bagi AI adalah kumpulan nilai numerik yang diolah menjadi dasar pengambilan keputusan.

Banyak sistem AI modern, terutama yang berbasis deep learning, bekerja seperti kotak hitam. Kita bisa melihat hasil akhirnya, apakah benar atau salah, tetapi sering kali tidak tahu alasan di balik keputusan tersebut. Bahkan para pengembangnya pun tidak selalu bisa menjelaskan mengapa suatu output dihasilkan dengan cara tertentu. Di sinilah muncul masalah kepercayaan antara manusia dan mesin.

Ketidakmampuan AI untuk menjelaskan alasannya menjadi persoalan serius ketika ia digunakan di bidang sensitif seperti kesehatan, keuangan, hukum, dan pendidikan. Keputusan yang salah bukan sekadar soal akurasi rendah, tetapi juga soal tanggung jawab. Tanpa penjelasan yang bisa dipahami manusia, kesalahan sulit ditelusuri, bias sulit dideteksi, dan dampak sosialnya bisa sangat besar.

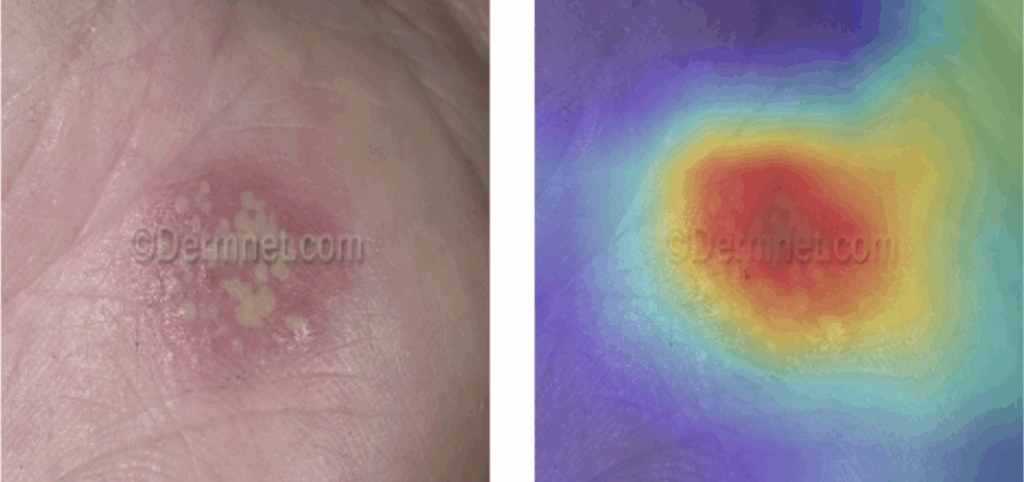

Di sinilah Explainable AI atau XAI menjadi penting. XAI bertujuan membuat AI tidak hanya memberi jawaban, tetapi juga menunjukkan alasan di baliknya. Beberapa pendekatan yang digunakan antara lain Shapley Value (SHAP) untuk mengukur pengaruh setiap fitur terhadap keputusan, Saliency Map untuk menunjukkan area paling sensitif dalam suatu data, serta Grad-CAM untuk memvisualisasikan bagian gambar yang paling diperhatikan model saat membuat prediksi.

Gambar 2: Contoh visualisasi Grad-CAM yang menunjukkan area gambar

Gambar 2: Contoh visualisasi Grad-CAM yang menunjukkan area gambar

yang paling memengaruhi keputusan AI.

Di masa depan, AI yang paling dibutuhkan bukan hanya yang paling pintar, tetapi yang paling bisa dipercaya. Kepercayaan tidak lahir dari akurasi semata, melainkan dari transparansi. Ketika manusia mulai memahami apa yang sebenarnya “dilihat” AI saat mengambil keputusan, saat itulah kecerdasan buatan benar-benar bisa menjadi mitra yang aman, adil, dan bertanggung jawab bagi kehidupan manusia.

Comments :